Repensando las prácticas de seguridad y control. Una reflexión desde la metáfora del adversario

- 07/08/2019

- Internacional

Por Jeimy Cano, Ph.D,

CFE

Director Revista SISTEMAS

at Asociación Colombiana

de Ingenieros de Sistemas

-ACIS-

En el ejercicio de protección y aseguramiento de los sistemas de información de las empresas, y en las exigencias propias de la dinámica empresarial, la seguridad/ciberseguridad se configuran, no sólo como aspectos claves del cumplimiento normativo, sino como elementos fundamentales de la gestión de las organizaciones en un contexto digital y tecnológicamente modificado como el actual.

Frente a esta realidad, los ejecutivos de seguridad/ciberseguridad han venido desplegando y aplicando prácticas de protección, que han configurado una lectura base del desarrollo de su descripción de cargo. En este contexto, los estándares y buenas prácticas han mantenido un liderazgo en las decisiones de estos profesionales, como una forma de concretar la confianza digital requerida para motivar y avanzar en la exigente tarea de acompañar las diferentes iniciativas de negocio, que muchas veces, generan tensiones con los modelos tradicionales de control.

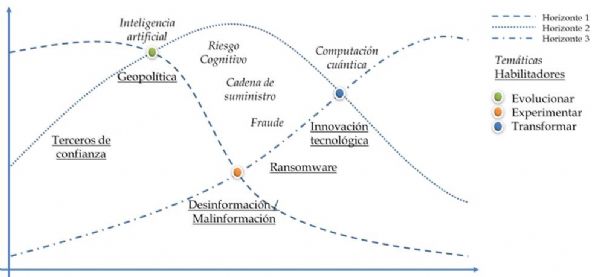

Si bien, las normas ISO asociadas con seguridad y control han cumplido una labor relevante para constituir una línea base de protección en las organizaciones, los cambios acelerados y la incorporación de nuevas tecnologías, hacen que su efectividad y relevancia comiencen a ceder terreno en escenarios donde la conectividad y las capacidades de los adversarios se hacen cada vez más inesperadas y novedosas, creando un entorno incierto, que demanda una vista distinta y una renovación acelerada de las prácticas vigentes.

Una de las propuestas frente a este nuevo contexto, es precisamente tratar de modelar al adversario y desde allí, de forma proactiva, intervenir y validar las medidas de seguridad y control establecidas por las organizaciones. De acuerdo con Biggio, Fumera & Roli (2014) modelar al adversario implica estudiar al menos cuatro características:

Objetivo: Se define en función de la violación de la seguridad deseada y de la especificidad del ataque.

Conocimiento: puede dividirse en dos (2) grupos denominados conocimiento restringido y conocimiento completo del escenario o contexto para generar el ataque.

Capacidad: posibilidad de controlar o alterar variables del contexto del sistema o aplicación objetivo.

Estrategia de ataque: es el comportamiento específico que busca manipular los datos o variables identificadas para lograr sus objetivos de manera efectiva.

Cuando se complementa la vista de aseguramiento de un entorno o sistema de información, con estos cuatro elementos, se establece un marco de pruebas de mal uso, que permite tanto a los diseñadores como a los usuarios, comprender mejor las posibilidades que se pueden presentar y cómo abordar los posible efectos adversos que esta dinámica puede traer al objeto o sistema que se quiere asegurar.

De esta manera, las prácticas vigentes de control de acceso y endurecimiento de los entornos de ejecución de las aplicaciones y sistemas de información, se someten al escrutinio de la vista del adversario, generando las tensiones necesarias y suficientes que permitan aumentar la confiabilidad de la solución planteada, y concretar ahora, una confianza digital más informada, donde es claro que siempre habrá espacios para que se materialice la inevitabilidad de la falla y que la organización muestre su capacidad para atender y superar un evento no previsto en su infraestructura.

Considerando estas dos vistas, la de los analistas de seguridad, así como la de los adversarios, se establecen de forma equivalente ejercicios de defensa más elaborados, no solo basados en un marco general de controles conocidos, sino en una clasificación y reinvención de los mismos, sabiendo que el objetivo no es la prevención total de evento no deseado, sino aumentar el tiempo, la incertidumbre, la dificultad y el esfuerzo del adversario para concretar un acción no autorizada sobre una infraestructura.

En este sentido, se configuran un conjunto de controles o medidas disuasivas, que permitan concretar las cuatro variables enunciadas para los marcos de defensa. La clasificación de estas medidas se puede definir de la siguiente forma:

Medidas proactivas: Estrategias de desinformación que escondan información al adversario aumentando la incertidumbre sobre el conocimiento del sistema que quiere atacar. En concreto, crear respuestas aleatorias de los sistemas objetivo, respecto de sus parámetros y variables claves.

Medidas reactivas: Estrategias basada en recolección y análisis de datos de actividades maliciosas o no autorizadas, que permitan aprender de situaciones pasadas, para detener o atacar de forma previa las acciones del atacante antes de que tenga éxito. En particular, utilizar sistemas de honeypot para capturar muestras de los ataques, analizarlos y fundar las acciones de control correspondientes.

Medidas anticipativas. Estrategias basadas en patrones de comportamiento de los atacantes, sustentadas en soluciones con implementación de algoritmos de aprendizaje profundo (bien supervisado, no supervisado o de refuerzo) (Broussard, 2018), sin perjuicio de la explotación de esta misma tecnología por parte de los adversarios de forma ofensiva, es decir, como una herramienta para evadir sistemas de patrones de reconocimiento (Li, Zhao, Cai, Yu & Leung, 2018). De manera práctica, desarrollar y asegurar los datos de entrenamiento y sus etiquetas, para practicar, afinar y mejorar la sensibilidad del modelo de aprendizaje y así tomar las medidas y ajustes de los sistemas de control definidos de forma anticipada.

Implementar medidas de aseguramiento como las expuestas anteriormente, buscan ir al terreno mismo del atacante, para manejar el mismo incierto que él desea concretar en su oponente, aumentando el tiempo, la incertidumbre, la dificultad y el esfuerzo del adversario, generando condiciones que permitan crear un contexto de disuasión creíble, sustentado en una postura de seguridad/ciberseguridad dinámica y situada en la realidad misma del agresor.

De esta manera, no se advierte una posición pasiva o reactiva en la vista del analista del seguridad, sino una postura propositiva y dinámica que permite aumentar su nivel de aprendizaje y protección de su infraestructura, no desde la búsqueda de certezas, sino desde la comprensión de la inestabilidad que es natural a la forma como se generan y concretan los posibles ataques.

En este nuevo escenario de prácticas de seguridad y control, el atacante se vuelve parte fundamental de las revisiones y análisis de los especialistas de seguridad, creando no solamente una consciencia situacional propia de los entornos de guerra militares, sino una renovación permanente de la base conceptual y operacional de los controles de seguridad, que da cuenta de una capacidad emergente necesaria en un mundo volátil, incierto, complejo y ambiguo como lo es la resiliencia y de competencias claves para ver la realidad en perspectiva, como son el pensamiento crítico, la visión sistémica y la deconstrucción de los saberes previos.

Referencias

Biggio, B., Fumera, G. & Roli, F. (2014). Pattern recognition systems under attack: design issues and research challenge. International Journal of Pattern Recognition and Artificial Intelligence. 28(7). Doi: 10.1142/S0218001414600027

Li, P., Zhao, W., Cai, W., Yu, S. & Leung, V. (2018). A Survey on Security Threats and Defensive Techniques of Machine Learning: A Data Driven View. IEEE Access. 6, 12103-12117. Doi: 10.1109/ACCESS.2018.2805680

Broussard, M. (2018) Artificial Unintelligence. How computers misunderstand the world. Cambridge, MA. USA: MIT Press.